Table of Contents

- Kernpunkte des Vergleichs

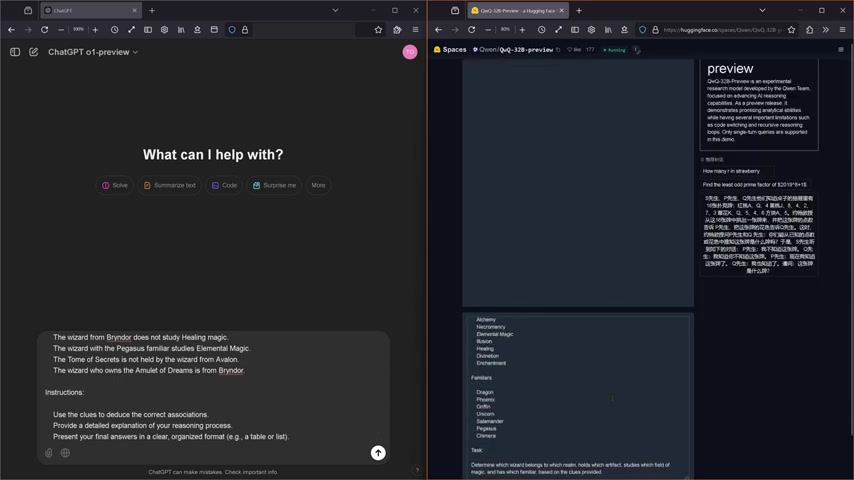

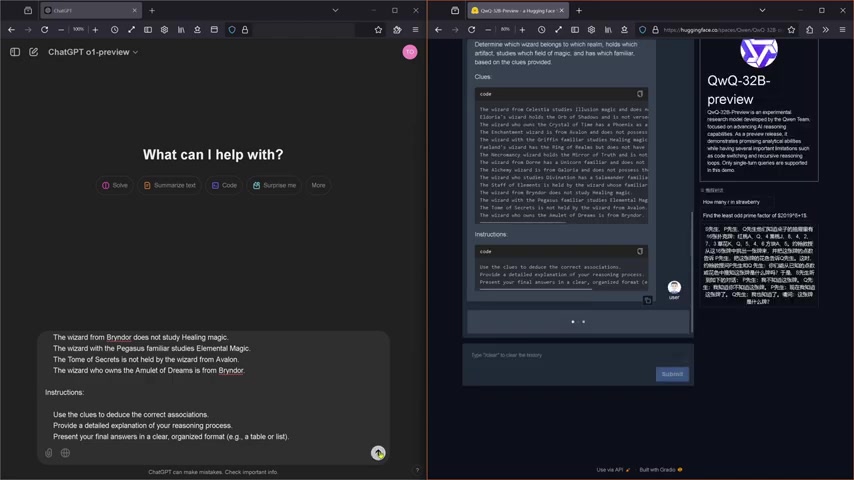

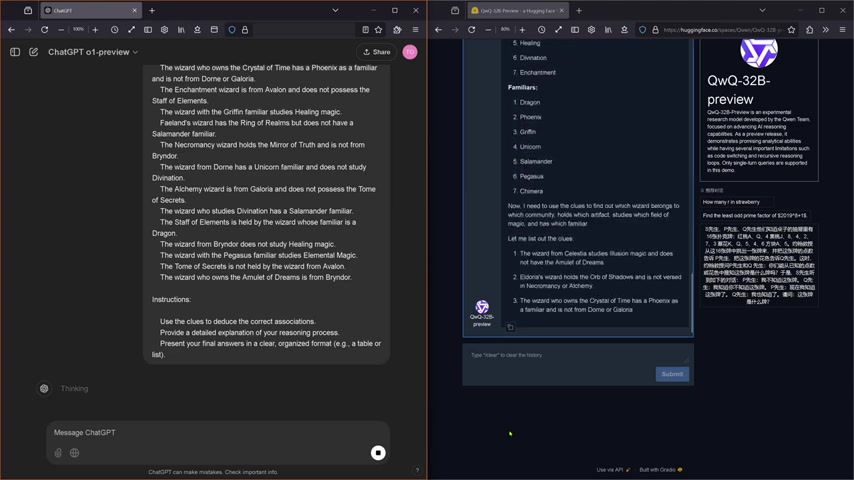

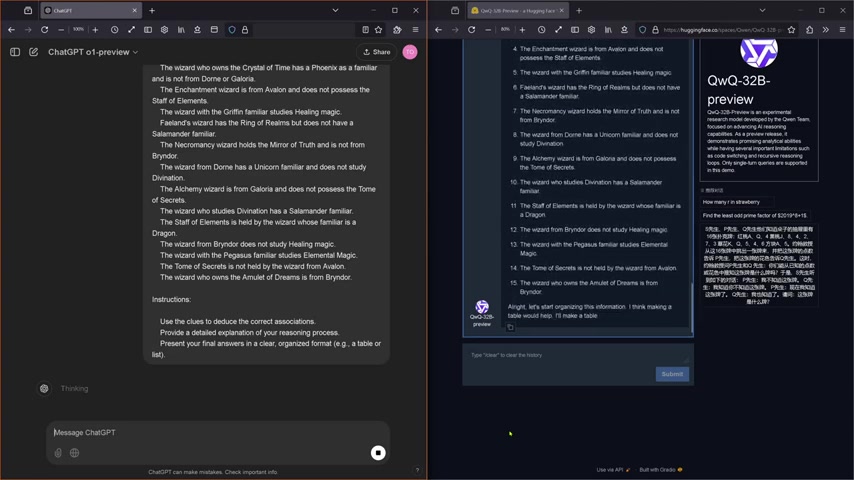

- Der Logiktest: Das Mysterium der sieben Artefakte

- Der Vergleich: Geschwindigkeit, Transparenz und Argumentation

- Verwendung von Qwen QwQ-32B für anspruchsvolle Logiktests

- Die Vor- und Nachteile von OpenAI o1-Preview

- Häufig gestellte Fragen (FAQ)

- Verwandte Fragen zur KI-Entwicklung

Most people like

< 5K

< 5K

0

0

< 5K

< 5K

0

0

8.7K

8.7K

0

0

137.9K

137.9K

14.05%

14.05%

3

3

713.6K

713.6K

15.23%

15.23%

3

3

- App rating

- 4.9

- AI Tools

- 100k+

- Trusted Users

- 5000+

WHY YOU SHOULD CHOOSE TOOLIFY

WHY YOU SHOULD CHOOSE TOOLIFY

TOOLIFY is the best ai tool source.

- Die Bedeutung von 14 Nanometern in Prozessoren entschlüsselt!

- AMD 1090 CPU: Ein leistungsstarker Desktop-Prozessor

- Maximieren Sie die Leistung Ihres AMD 1055T Phenom II X6 mit Overclocking!

- AMD: Zen 4-Prozessoren und V-Cash CPUs - Rasant entwickelnde Technologiebranche

- Verantwortungsvoller KI-Einsatz bei Intel: Innovative Anwendungen und Deepfake-Erkennung

- La revolución de la inteligencia artificial y el CEO de NVIDIA: Perspectivas del futuro

- ¡Potente procesador de juegos! i3 3220 - Rendimiento, precio y recomendaciones

- AMD vs Nvidia: Welche Grafikkarte ist die beste Wahl für Gaming?

- AMD PBO2 vs. CTR: Die ideale Curve-Optimierer-Anzahl pro Kern finden

- Die Zukunft der Deep Fake-Erkennung: Intel Fake Catcher