AI로 더 나은 AI 만들기

Table of Contents

- 개요 🌟

- 새로운 NFTpy 버전 3 소개 🚀

- 업데이트 내용 확인 및 Argos 프레임 업데이트 필요성 검토 🔍

- 설명 종이(Explain Paper)와 GitHub Copilot 소개 🤖

- AI 도구를 활용한 OpenNMT 및 Argos 교육 콘텐츠 개발 💡

- OpenNMT 및 Argos 훈련에 대한 배경 정보 제공 😊

- Torchtext의 업데이트에 따른 OpenNMTpy V3 변경 사항 😮

- 데이터 로딩 API 간소화를 위한 Torchtext 제거 😌

- 실시간 데이터 처리를 위한 패러다임 유지 ✨

- 샤딩 전략의 필요성 검토 🔎

- 데이터 처리에 따른 변경 사항 시뮬레이션 🔄

- 트렌스포머 인코더의 새로운 위치 인코딩 방식 💡

- 최대 상대 위치 인코딩의 효율성 및 장점 📚

- 모델 성능 향상을 위한 알고리즘 변경 🚀

- GPU RAM 용량에 맞는 배치 크기 설정하기 ⚙️

- 데이터셋 전처리 시 버킷 크기 조절하기 🗄️

- 체크포인트 관리 시 주의 사항 ⚠️

- 문장 길이 패널티 적용을 통한 결과 개선 ✅

- OpenNMTpy V3의 장점과 한계 🎯

- 업데이트 내용 요약 📝

- FAQ 🙋♂️

개요 🌟

안녕하세요! 최근에 새롭게 출시된 OpenNMTpy 버전 3에 대해 알아보려고 합니다. 이번 비디오에서는 이 변경 사항을 검토하고, 이를 반영하여 제가 개발한 Argos 프레임을 업데이트해야 할 필요성을 검토할 계획입니다. 또한, 컴퓨터 프로그래밍을 위한 두 가지 인공지능(AI) 도구인 Explaining Paper와 GitHub COPILOT을 사용하여 이러한 도구의 기능을 소개하고 OpenNMT와 Argos의 교육 콘텐츠를 함께 제작하는 것이 목표입니다. 최근 두 해 동안 언어 모델들이 지속적으로 발전해 왔으며, 심지어 매달 큰 향상이 이루어지고 있습니다. 이는 매우 놀라운 일이며 매우 유용한 도구로서 사용될 수 있습니다. 이러한 AI 도구를 사용하여 더 나은 AI를 훈련시키는 것은 당연한 일일 것입니다. 따라서 오늘은 이에 대해 작업해 보려고 합니다. Brave에서 PDF 파일로 내보낸 포럼 게시물을 Explain Paper로 업로드하여 내용을 확인한 뒤 Argos 훈련에 어떤 업데이트를 해야 할지 검토할 계획입니다. 그럼 시작해보겠습니다. 하지만 OpenNMTpy 3.0은 공개되지 않도록 부탁드립니다. OpenNMTpy는 Neural Machine Translation을 위한 파이썬 라이브러리로, OpenNMTpy의 세 번째 주요 업데이트인 OpenNMTpy V3입니다. 이 코드 검토에서 이를 명시적으로 언급하고 있습니다. 또한, 이를 아티스트라고 부르고 있어 좀 의아합니다.

새로운 NFTpy 버전 3 소개 🚀

OpenNMTpy 버전 3은 Neural Machine Translation을 위한 파이썬 라이브러리로, 세 번째 주요 업데이트를 진행한 것이 특징입니다. 이는 공식적인 연구 논문으로 언급되어 있으며, 맞는 내용입니다. 업데이트 내용을 살펴보면 기존의 Torchtext에 의존하던 데이터 로딩 API를 단순화하고 삭제한 사실이 나와 있습니다. 이는 OpenNMTpy의 범위에서 Torchtext를 완전히 제거하려는 결정으로 이루어졌으며, 이는 옳은 결정으로 보입니다. 데이터 로딩 API의 단순화를 통해 데이터셋을 쉽게 조정하고 특정 내용 도메인에 대한 가중치를 변경할 수 있으며, 미리 정의된 버킷 크기와 함께 반복 가능한 데이터셋으로 데이터를 로드합니다. 공개 NFT와 관련된 궁금한 점이 있으신가요? 안타깝게도 지금은 OpenNMTpy 3.0을 공개할 수 없습니다. OpenNMTpy는 파이썬에서 Neural Machine Translation을 수행하는 데 사용되는 파이썬 라이브러리입니다. 제작자가 이 코드를 설명하고 업데이트하는 사람인 것 같습니다. OpenNMTpy V3의 주요 동기는 훈련 중 사용되는 Old version of torch text에 의존하는 데이터 로딩 API를 단순화하는 것입니다. 이는 올바르게 기술하고 있으며, torch text의 이동은 OpenNMTpy의 데이터 로딩 API를 간소화할 것으로 예상됩니다. 오히려 torch text 모듈을 완전히 제거하기로 결정하여 데이터 처리에 간편함을 제공합니다. 이는 다른 도구와 비교했을 때 더 적은 데이터 전처리가 필요하게 됩니다. 따라서 이전처럼 많은 양의 데이터를 샤딩할 필요가 없어집니다.

업데이트 내용 확인 및 Argos 프레임 업데이트 필요성 검토 🔍

변경 사항 중 하나는 데이터 로딩 API를 단순화했다는 점입니다. 기존의 Torchtext에 대한 종속성을 제거하여 데이터 로딩 API를 보다 간편하게 만들었습니다. 업데이트의 주요 동기는 훈련에 사용되는 데이터 로딩 API를 간소화하는 것이었습니다. 이로 인해 Torchtext의 범위를 OpenNMTpy로부터 완전히 제거하기로 결정했습니다. 따라서 Argos 프레임의 업데이트가 필요한지 검토해야 합니다. Argos 프레임은 OpenNMTpy를 기반으로 개발된 어플리케이션입니다. 이 변경 사항에 맞춰서 Argos 프레임도 업데이트가 필요할지 고려해야 합니다. 이전 버전과의 이진 호환성을 업그레이드하는 과정에서 생기는 어려움을 피하기 위해 직접적인 체크포인트 저장을 보다 향상시키고자 합니다. 다음 단계에서는 궁극적으로 이런 어려움을 해결하기 위한 더 나은 체크포인트 지원을 추가할 예정이지만, 현재로서는 훈련을 새롭게 시작하여 업그레이드하는 것이 제일 간단한 방법인 것 같습니다. OpenNMTpy와 Argos 프레임을 함께 사용하고 있는 점을 감안할 때, 이러한 변경이 모델 훈련에 긍정적인 영향을 미칠 것으로 보입니다.

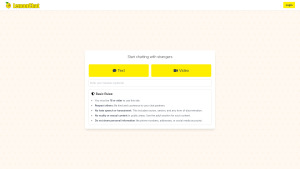

설명 종이와 GitHub Copilot 소개 🤖

이제 설명 종이와 GitHub Copilot을 소개하겠습니다. 이 두 가지 인공지능(AI) 도구는 컴퓨터 프로그래밍을 위해 사용됩니다. 설명 종이는 AI 기반 도구로, PDF 파일을 업로드하여 내용을 분석하고 해석하는 데 사용됩니다. GitHub Copilot은 GitHub에서 제공하는 AI 도구로, 코드 작성을 보조해주는 역할을 합니다. 이 두 가지 도구를 이용하여 OpenNMT와 Argos의 훈련을 자동화하고, 보다 효율적인 결과물을 얻을 수 있도록 노력할 예정입니다. 최근 두 해 동안 언어 모델들이 계속 발전했고, 매월 큰 향상이 이루어지고 있습니다. 이는 놀라울 정도로 좋아져서 매우 일반적인 수준의 작업에 유용하게 사용될 수 있습니다. 저는 더 이상 지능이 증가하지 않기 때문에 이러한 AI 도구를 사용하여 더 나은 AI를 얻는 것이 목표입니다. 따라서 오늘은 이러한 AI 도구를 사용하여 더 나은 AI를 훈련시키는 것이 목표입니다. 먼저, Brave에서 PDF로 내보낸 포럼 게시물을 설명 종이에 업로드하여 내용을 확인하고, Argos 훈련에 어떤 업데이트를 해야 할지 확인할 계획입니다.

AI 도구를 활용한 OpenNMT 및 Argos 교육 콘텐츠 개발 💡

이번에는 설명 종이와 GitHub Copilot 등의 AI 도구를 활용하여 OpenNMT와 Argos의 교육 콘텐츠를 개발하는 방법에 대해 알아보겠습니다. 최근에는 언어 모델이 지속적으로 발전해오고 있으며, 특히 최근 2년간 기술이 더욱 향상되고 있습니다. 이제 언어 모델은 실용적인 일반적인 작업에 매우 유용하며, 매달 업데이트되고 있는 모습을 보여주고 있습니다. 저 같은 경우에는 지능적으로 더 이상 성장하지 않으므로, 이러한 AI 도구를 사용하여 더 나은 AI를 얻을 수 있는 가능성을 탐구하고자 합니다. 따라서 OpenNMT와 Argos의 훈련을 자동화하기 위해 설명 종이와 GitHub Copilot 등의 AI 도구를 활용할 예정입니다. Brave에서 PDF 파일로 내보낸 포럼 게시물을 설명 종이에 업로드하고, 내용을 검토한 뒤 Argos 프레임을 업데이트할 필요가 있는지 판단하려고 합니다.

OpenNMT 및 Argos 훈련에 대한 배경 정보 제공 😊

OpenNMT는 Neural Machine Translation을 위한 파이썬 라이브러리로, OpenNMTpy는 OpenNMTpy의 세 번째 주요 업데이트인 OpenNMTpy V3입니다. 이 라이브러리는 Neural Machine Translation을 위한 파이썬 라이브러리로 자주 사용됩니다. OpenNMTpy V3은 광범위한 변경 사항을 포함한 중요한 업데이트입니다. 그러나 이번 비디오에서는 OpenNMTpy 3.0에 대한 자세한 내용을 공개할 수 없기 때문에 주의해주세요. OpenNMTpy 3.0은 Python을 기반으로 한 Neural Machine Translation을 위한 파이썬 라이브러리입니다. 이 코드 검토에서 OpenNMTpy 3의 주요 동기는 Torchtext의 이전 버전에 의존하는 데이터 로딩 API를 단순화하는 것이었습니다. 이로 인해 Torchtext의 범위를 OpenNMTpy에서 제외하기로 결정했습니다. 이를 통해 데이터 로딩 API가 더욱 간소화되었으며, 다른 도구에 비해 데이터 전처리에 필요한 작업이 줄었습니다. 따라서 데이터셋을 샤딩할 필요가 없어졌습니다.

Torchtext의 업데이트에 따른 OpenNMTpy V3 변경 사항 😮

변경 사항 중 주요한 내용은 Torchtext의 업데이트에 따른 OpenNMTpy V3의 변경입니다. 이전 버전의 OpenNMTpy에서는 Torchtext를 사용하여 데이터 로딩 API를 구현했습니다. 그러나 OpenNMTpy V3에서는 Torchtext의 종속성을 완전히 제거하고 데이터 로딩 API를 단순화했습니다. 이로 인해 데이터 전처리에 필요한 번거로움이 사라졌습니다. 이제 OpenNMTpy에서 데이터를 로드할 때 다른 도구에 비해 더 적은 전처리 작업이 필요합니다. 그러나 Torchtext 대신 사용할 데이터 로딩 API를 찾아야 할 수도 있습니다. 설명 종이에 따르면 OpenNMTpy에 Torchtext 대신 최대 상대 위치 인코딩을 사용하기를 권장합니다. 최대 상대 위치 인코딩은 문장 내 단어들의 상대적인 위치를 이용한 인코딩 방식입니다. 이는 메모리 효율성이 높고 계산 속도가 빠르다는 장점을 가지고 있습니다. 현재 설정된 기본값은 torchtext로 설정되어 있어 변경이 필요합니다. 따라서 Argos 프레임의 설정 파일인 config.yaml에서 해당 항목 값을 변경해주어야 합니다.

데이터 로딩 API 간소화를 위한 Torchtext 제거 😌

Torchtext의 종속성을 OpenNMTpy V3의 범위에서 제거하는 결정은 데이터 로딩 API의 간소화를 위한 것입니다. Torchtext에 종속되어 있던 이전 버전의 OpenNMTpy와 달리, OpenNMTpy V3는 더욱 간결한 데이터 로딩 API를 제공합니다. 이 변경으로 인해 데이터 전처리에 필요한 작업이 줄어들고 다른 도구에 비해 더 적은 패딩 작업이 필요하게 됩니다. 설명 종이에 따르면 Torchtext를 사용하지 않고 데이터를 직접 로딩할 수 있게 되었습니다. 따라서 Argos 프레임의 데이터 로딩 코드 역시 Torchtext 종속성을 제거하고 변경해야 할 것입니다. Torchtext 종속성을 제거하면 데이터 로딩 속도와 메모리 사용량 측면에서 이점이 있습니다. 따라서 Argos 프레임을 업데이트하여 Torchtext를 사용하지 않도록 변경하는 것이 좋을 것입니다.

실시간 데이터 처리를 위한 패러다임 유지 ✨

OpenNMTpy V3에서는 실시간 데이터 처리를 위한 패러다임을 계속 유지하고 있습니다. 이는 데이터를 실시간으로 처리하여 데이터셋의 크기를 최소화하고 특정 내용 도메인에 대한 가중치를 조정할 수 있다는 장점을 가지고 있습니다. 이를 통해 데이터셋을 쉽게 조정하고 각 소스별 가중치를 변경하여 특정 내용 도메인을 다른 내용 도메인에 우선시할 수 있습니다. 또한, 정의된 버킷 크기로 데이터셋을 로드하기 때문에 많은 수의 패딩이 필요하지 않습니다. 설명 종이의 내용에 따르면 다른 도구와 비교했을 때 데이터셋을 실시간으로 처리할 수 있어 더 많은 메모리를 사용하지 않아도 빠르고 효율적인 작업이 가능합니다.

샤딩 전략의 필요성 검토 🔎

샤딩 전략에 대한 필요성을 검토해야 합니다. 샤딩 전략은 데이터베이스를 작은 조각으로 나누는 프로세스를 시작하는 것을 말합니다. 각 조각 단위로는 데이터베이스에 저장된 일부 데이터가 포함되어 있습니다. 설명 종이의 내용을 살펴보면 데이터를 샤딩할 필요가 없다고 언급하고 있습니다. 따라서 OpenNMTpy V3의 데이터셋은 이터러블 데이터셋으로 로드되며, 미리 정의된 버킷 크기로 처리됩니다. 미리 정의된 버킷 크기를 사용하면 데이터셋을 샤딩할 필요가 없습니다. 따라서 더 이상 데이터를 여러 조각으로 분할할 필요가 없습니다.

데이터 처리에 따른 변경 사항 시뮬레이션 🔄

데이터 처리에 따른 변경 사항 시뮬레이션을 진행해보겠습니다. 설명 종이의 내용을 살펴보면, 이번 변경 사항으로 데이터 처리 API가 간소화되어 더 이상 데이터를 사전 처리할 필요가 없다고 언급하고 있습니다. 다른 도구에서는 데이터 사용을 위해 사전 처리 작업을 수행해야 하지만, OpenNMTpy V3에서는 사전 처리 작업을 할 필요가 없습니다. 따라서 별도의 작업 없이 데이터셋을 변경할 수 있습니다. OpenNMTpy에서는 학습 과정에서 작은 오버헤드로 인한 추가적인 작업도 가능하게 하였습니다. 이는 훈련 과정에서 체크포인트를 평균화하여 특정 체크포인트에서의 이상 현상을 완화시킵니다. 현재 Argos 훈련에서도 이를 적용하고 있는데, 50,000번의 체크포인트를 평균화하여 49,000번의 체크포인트와 유사한 결과를 얻으려고 합니다. 다른 도구에서는 훈련 과정에서 점진적으로 평균화를 수행하도록 권장하고 있으므로, 이와 유사하게 적용해볼 수도 있습니다. 이미 평균화를 수행하고 있다면 추가 변경이 필요한지에 대해서는 검토해야 할 것입니다.

트렌스포머 인코더의 새로운 위치 인코딩 방식 💡

트랜스포머 인코더의 새로운 위치 인코딩 방식에 대해 알아보겠습니다. 기존의 위치 인코딩 방식은 사인 함수를 사용한 삼각함수 기반 위치 인코딩입니다. 이는 입력 임베딩을 입력 순서에 따라 곱한 다음 사인 함수를 통과시켜 모델이 입력 시퀀스의 위치를 파악할 수 있도록 합니다. 그러나 설명 종이에서는 이러한 방식의 사용을 권장하지 않고, 최대 상대 위치 인코딩을 사용할 것을 권장하고 있습니다. 최대 상대 위치 인코딩은 문장 내 단어들의 상대적인 위치를 이용하여 위치를 인코딩하는 방식입니다. 이는 더 효율적이고 작업 속도가 더 빠르다는 장점을 가지고 있습니다. 그러나 현재 설정 값은 "false"로 되어 있는데, 이 값은 Torchtext를 사용하고 있음을 의미합니다. 따라서 Argos 훈련에 적용하기 위해 config.yaml 설정 파일에서 해당 값을 "true"로 변경해주어야 합니다.

최대 상대 위치 인코딩의 효율성 및 장점 📚

최대 상대 위치 인코딩은 상대적인 위치를 이용한 위치 인코딩 방식으로, 문장 내 단어들의 최대 상대 위치를 활용합니다. 이전의 절대 위치 인코딩 방식과 비교하면 메모리 측면에서 훨씬 효율적이며 계산 속도도 빠릅니다. 최대 상대 위치 인코딩은 단어의 상대적인 위치만을 고려하기 때문에 더 적은 메모리를 사용하고 계산 속도도 더 빠릅니다. 이는 이전에 고려한 절대 위치 인코딩보다 훨씬 효율적이라는 것을 의미합니다. 따라서 최대 상대 위치 인코딩은 Argos 프레임의 성능을 향상시킬 수 있는 매우 유용한 변경 사항입니다.

모델 성능 향상을 위한 알고리즘 변경 🚀

모델 성능 향상을 위한 알고리즘 변경이 있습니다. 기존에는 최적의 성능과 속도를 제공하는 Torchtext를 사용하였으나, OpenNMTpy V3에서 이를 제거하고 최적화된 코드인 FusedAdam을 사용하도록 변경되었습니다. FusedAdam은 최신의 PyTorch와 맞춰진 버전이며, Floating Point 16(APEX level 0102)을 지원합니다. 테스트 결과, FusedAdam은 이전 버전의 Torchtext와 비교하여 훨씬 더 느려졌습니다. 따라서 OpenNMTpy V3에서는 FusedAdam을 사용하는 것을 권장하고 있습니다. 현재 Argos 훈련에서도 FusedAdam을 사용하고 있으며, 변경된 알고리즘으로 인해 더 나은 성능과 속도를 기대할 수 있습니다.

GPU RAM 용량에 맞는 배치 크기 설정하기 ⚙️

GPU RAM 용량에 맞는 배치 크기를 설정해야 합니다. 설명 종이에서는 가능한 한 GPU RAM 용량에 맞는 최대 배치 크기를 사용할 것을 권장하고 있습니다. 이렇게 하면 최상의 결과를 얻을 수 있습니다. 즉, GPU가 8192 토큰을 처리할 수 있다면, 적어도 이를 반영한 배치 크기를 지정해야 합니다. 예를 들어, GP CU RAM 용량이 8192 토큰을 수용할 수 있는 경우, accumulation count가 12인 경우 실제 배치 크기는 98304 토큰이 됩니다. 현재 설정된 값에 대한 확인이 필요합니다. 현재 설정된 값을 확인하기 위해 config.yaml 파일을 확인하도록 하겠습니다. Argos 훈련에서는 배치 크기를 4096으로 설정하고 있습니다. 그러나 실제 GPU 메모리에서 사용되는 양은 이보다 적을 수 있다는 것을 확인하였습니다. 따라서 배치 크기를 더 늘려서 사용해볼 필요가 있어 보입니다. 이에 대한 확인을 위해 두 가지 도구인 설명 종이와 GitHub Copilot을 활용해 보겠습니다.

데이터셋 전처리 시 버킷 크기 조절하기 🗄️

버킷 크기를 조절하여 데이터셋 전처리를 진행해야 합니다. 설명 종이에서는 버킷 크기를 2,200,000에서 500,000 사이로 설정하면 대부분의 경우에 적합하다고 언급하고 있습니다. 버킷 크기가 높을수록 패딩이 줄어들기 때문에 더 나은 결과를 얻을 수 있습니다. 버킷 크기를 늘릴수록 패딩 작업을 더 적게 수행해야 하기 때문에 적합한 값을 선택하는 것이 중요합니다. 따라서 Argos 훈련에 적합한 값을 선택해야 합니다. 현재 설정된 값은 32,000입니다. 이는 이전에 사용한 값과 비교하면 약간 적은 값입니다. 따라서 버킷 크기를 보다 큰 값으로 설정해보는 것이 좋을 것입니다. 현재 설정된 값과 인공지능 도구인 GitHub Copilot의 권장 값을 비교해보면서 적정한 값을 선택해야 합니다.

체크포인트 관리 시 주의 사항 ⚠️

체크포인트 관리 시 주의 사항이 있습니다. 설명 종이에서는 체크포인트에 대해 어떠한 변경도 수행하지 않고 있다고 언급하고 있습니다. 이는 OpenNMTpy에서 체크포인트를 저장하지 않고 처음부터 다시 훈련한다는 의미입니다. 이로 인해 이진 호환성을 업그레이드하는 데 어려움이 생기지 않으며, 훈련을 더욱 간단하게 진행할 수 있습니다. 현재 Argos 훈련에서는 체크포인트 저장을 수행하지 않고 있으며, 모든 훈련 과정을 처음부터 시작하여 업그레이드를 진행하고 있습니다. 나중에 체크포인트 관리에 대한 지원을 개선할 계획이지만, 현재로서는 이 방법이 가장 간단한 방법입니다.

문장 길이 패널티 적용을 통한 결과 개선 ✅

문장 길이 패널티를 적용하여 결과를 더욱 개선할 수 있습니다. 설명 종이에서는 기존의 디폴트 결과에 대해 길이 패널티를 적용하면 대부분의 경우 더 나은 결과를 얻을 수 있다고 언급하고 있습니다. 결과가 너무 긺이면 모델이 오류로 판단하여 더 큰 손실을 가지는 것이 일반적입니다. 따라서 길이 패널티를 적용하여 결과를 보다 적절하게 조정할 수 있습니다. 현재 설정값은 "average"로 되어 있어 추가 변경이 필요하지 않을 것 같습니다.

OpenNMTpy V3의 장점과 한계 🎯

OpenNMTpy V3의 장점과 한계를 알아보겠습니다. OpenNMTpy V3은 기존 버전과 비교하여 몇 가지 개선 사항이 있습니다. 먼저, 데이터 로딩 API가 간소화되었으며 Torchtext와의 종속성이 제거되었습니다. 이로 인해 데이터 전처리 작업을 더욱 간편하게 수행할 수 있게 되었습니다. 또한, 기존에는 성능과 속도에서 가장 우수한 퍼포먼스를 제공하는 Torchtext를 사용하였으나, 최신 버전의 OpenNMTpy V3에서는 FusedAdam으로 변경됨에 따라 성능이 더욱 향상되었습니다. 이로 인해 PyTorch 버전 1.13에서 Torchtext를 사용하는 것보다 더욱 빠른 결과를 얻을 수 있습니다. 그러나 OpenNMTpy V3의 한계점도 있습니다. 예를 들어, Torchtext와의 이진 호환성을 업그레이드하는 작업이 필요할 수 있으며, Argos 훈련에서는 이에 대한 추가 작업이 필요할 수 있다는 점을 염두에 두어야 합니다.

업데이트 내용 요약 📝

이번 OpenNMTpy V3의 업데이트 내용을 요약하자면 다음과 같습니다. Torchtext 종속성의 제거, 최대 상대 위치 인코딩의 도입, FusedAdam의 사용 등이 있습니다. 이러한 변경 사항을 통해 데이터 로딩 API가 간소화되고 훈련 속도와 성능이 개선되었습니다. 이러한 업데이트 내용을 반영하는 것이 Argos 프레임의 업데이트에 필요한 작업입니다.

FAQ 🙋♂️

Q: OpenNMTpy V3이 어떤 향상을 이루고 있나요?

A: OpenNMTpy V3은 Torchtext 종속성의 제거, 최대 상대 위치 인코딩의 도입, FusedAdam의 사용 등 몇 가지 향상 사항을 가지고 있습니다. 이로 인해 데이터 로딩 API가 간소화되고 훈련 속도와 성능이 개선되었습니다.

Q: Argos 프레임의 업데이트가 필요한 이유는 무엇인가요?

A: Argos 프레임은 OpenNMTpy를 기반으로 개발된 어플리케이션입니다. 따라서 OpenNMTpy의 업데이트에 따라 Argos 프레임도 업데이트가 필요합니다.

Q: GitHub Copilot이 도움이 되지 않은 이유는 무엇인가요?

A: GitHub Copilot은 이번 yaml 파일에서는 권장 사항을 제공하지 못한 것 같습니다. 따라서 기존에 설정된 값을 사용하는 것이 가장 적절한 선택일 것입니다.

90.8K

90.8K

50.53%

50.53%

2

2

< 5K

< 5K

0

0

1M

1M

44.54%

44.54%

0

0

< 5K

< 5K

1

1

76.7K

76.7K

50.9%

50.9%

0

0

WHY YOU SHOULD CHOOSE TOOLIFY

WHY YOU SHOULD CHOOSE TOOLIFY