Table of Contents

Most people like

< 5K

< 5K

0

0

< 5K

< 5K

100%

100%

0

0

884.5K

884.5K

22.78%

22.78%

0

0

< 5K

< 5K

0

0

< 5K

< 5K

2

2

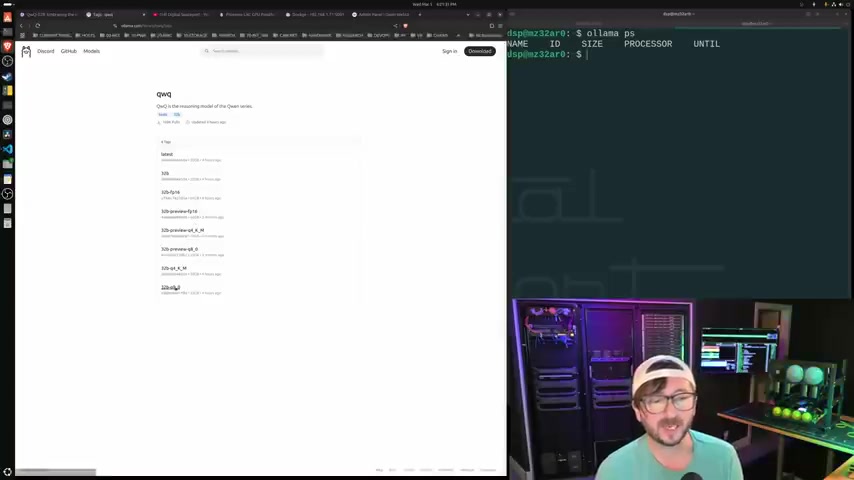

- App rating

- 4.9

- AI Tools

- 100k+

- Trusted Users

- 5000+

WHY YOU SHOULD CHOOSE TOOLIFY

WHY YOU SHOULD CHOOSE TOOLIFY

TOOLIFY is the best ai tool source.