数据爱好者的10个强大网络爬虫技巧

最佳 Web Scraping 在 2025

最后的话

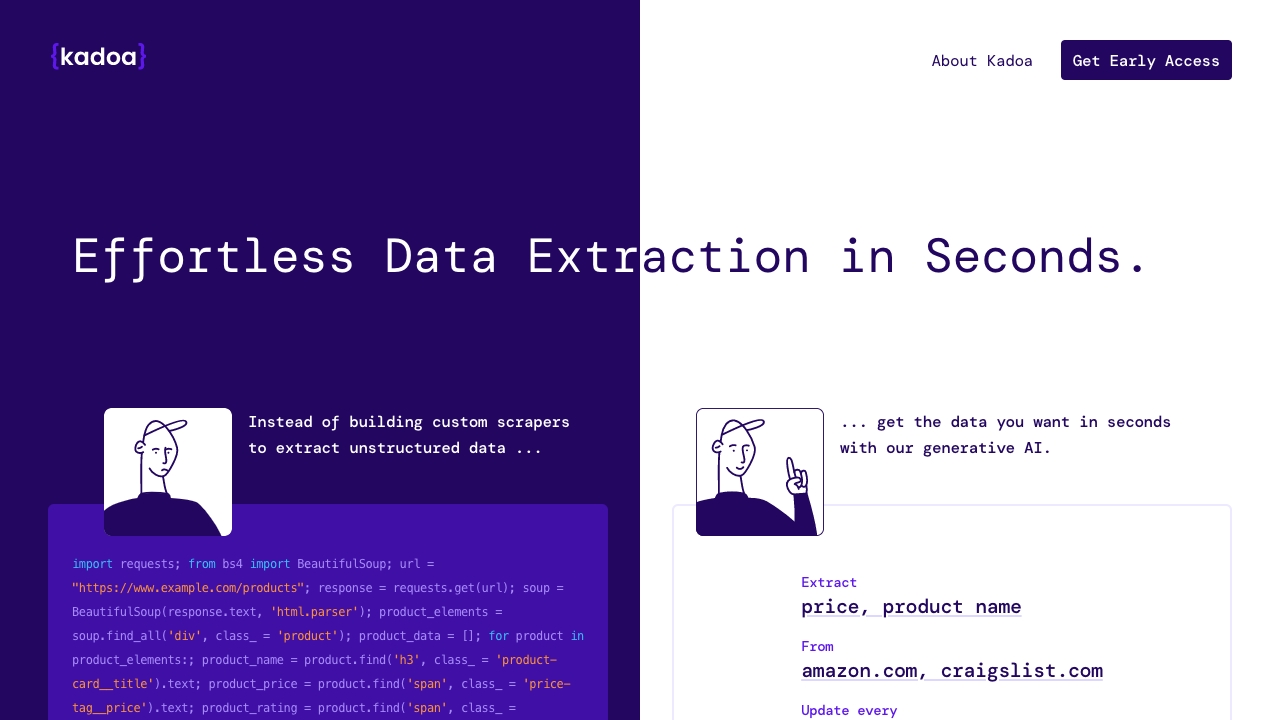

这篇文章介绍了各种由人工智能技术驱动的网络爬虫工具,每个工具都提供独特的功能和功能,以简化数据提取过程。 WebScraping.AI 提供了一个爬取 API,集成了 GPT API、代理和 HTML 解析,使爬取变得轻松。它提供了 JavaScript 渲染、轮换代理、快速 HTML 解析和 GPT 动力工具,用于高效的爬取。 Scrape Comfort 是一个由人工智能驱动的工具,消除了在网络爬虫中编码的需要。用户只需输入 URL,使用带有 JavaScript 的 Chrome 浏览器下载数据,使用简单语言设置提取器,轻松保存提取的数据。 Hexomatic 提供了网络爬取和自动化功能,允许用户从任何网站提取数据并自动执行各种任务。它提供了现成的自动化、人工智能集成和工作流创建,实现了无缝的数据提取和处理。 PhantomBuster 是一个基于网络的平台,促进数据提取、自动化和网络爬虫。它提供 API 连接器、数据丰富和可视化工具,以从在线来源检索和分析数据。 SheetMagic 使用人工智能和网络爬虫功能增强了 Google Sheets,实现了大量内容创建、数据提取和分析,直接在 Sheets 中进行。 Kadoa 使用生成式人工智能自动化定制网络爬虫进行数据提取,提供自动生成的网络爬虫、数据转换、智能爬行和 API 访问等功能。 Browse AI 是一个用户友好的网络自动化工具,用于数据爬取和监控,提供了预构建的机器人、批量运行能力、验证码解决以及与 7000 多个应用程序的集成。 Webscrape AI 在没有手动干预的情况下自动化网络爬取,提供易于使用的数据收集、准确的数据提取和可定制的偏好,以实现高效的数据检索。 My Email Extractor 是一个免费的电子邮件爬取工具,可以自动提取网站上的电子邮件、电话号码和社交资料,支持域到电子邮件查找功能,实现高效的数据提取。 Browserbear 提供了一个无代码网络爬虫工具,用于数据提取、浏览器自动化和 API 触发,具有任务构建、自动化测试、集成和自定义订阅等功能。 总的来说,这些由人工智能驱动的网络爬虫工具为企业提供了高效、经济、可定制的数据提取和自动化解决方案。

关于作者

I am an enthusiast and scholar in the field of artificial intelligence, with a passion for exploring the intersection of technology and human cognition. With a rich background in computer science and hands-on experience in machine learning, I have contributed to both academic research and practical applications of AI. My work aims to demystify the complexities of AI and make it accessible to a broader audience, fostering an understanding of its potential to transform our world.

更多AI工具

- 8 Creative Ways to Use AI Image Generators in Your Projects

- 15 Mind-Blowing AI Art Generators You Need to Try

- 7 Incredible Ways AI Generators Are Revolutionizing Content Creation

- 6 Powerful Ways Team Messaging Boosts Productivity and Collaboration

- 11 Proven B2B Marketing Strategies to Boost Your Business

- 10 Fascinating Facts About Motion Capture Technology